O impacto social da IA é profundo, com implicações nas áreas de trabalho, ciência, academia e até mesmo na saúde mental (Foto: Canva.com)

Mais do que responder qual será a previsão do tempo nos próximos dias ou tocar suas canções preferidas, as ferramentas de Inteligência Artificial (IA), especialmente as conversacionais e gerativas, estão reformulando a nossa relação com a tecnologia – e, por extensão, o futuro da internet.

Essa onda recente de inovação também significa novas perspectivas de pesquisa e debate para pesquisadores como Tiago Timponi Torrent, coordenador do laboratório FrameNet Brasil e doutor em Linguística. Torrent é um dos convidados pelo Centro de Estudos em Tecnologias Web (Ceweb) para debater um olhar interdisciplinar sobre a IA gerativa. A participação do pesquisador será transmitida ao vivo no canal do Núcleo de Informação e Coordenação do Ponto BR (NIC.Br), às 9h30, nesta quinta-feira, 18 de maio. O Ceweb integra o NIC.br, criado para implementar as ações do Comitê Gestor da Internet no Brasil (CGI.br), este último responsável por coordenar e integrar as iniciativas e serviços da Internet no Brasil.

Em ocasião do Dia da Internet, a Universidade Federal de Juiz de Fora (UFJF) conversou com Torrent e com o pesquisador Lucas Costa dos Anjos, que também traz uma visão multidisciplinar – atualmente, ele ocupa a posição de especialista na Coordenação-Geral de Tecnologia e Pesquisa da Autoridade Nacional de Proteção de Dados (ANPD), além de integrar o projeto The New Digital Rule of Law, que promove o entendimento das normas digitais emergentes do século XXI. Dos Anjos lecionou no curso de Direito do campus avançado da UFJF em Governador Valadares entre 2017 e 2021.

A “alucinação” artificial e os desafios da regulamentação

“Precisamos pensar que uma ferramenta nova, qualquer que ela seja, abre possibilidades e, muitas vezes, rompe com modos de fazer com os quais nós estávamos acostumados”, pondera Torrent. “Nesse primeiro momento, precisamos estar muito atentos porque haverá exageros.” Um exemplo citado é o Efeito Eliza, como é chamada a tendência das pessoas em atribuir a uma máquina uma intencionalidade e uma habilidade intelectual que ela, na verdade, não possui.

O pesquisador Tiago Torrent debate sobre IA gerativa em evento online nesta quinta, 18 de maio (Foto: Carolina de Paula/UFJF)

O nome é uma referência ao primeiro chat bot, chamado Eliza, que funcionava como uma psicanalista que respondia os usuários com frases vagas, como “pode explicar melhor?” ou “e por que você acha que isso ocorre?”. “Na verdade, a Eliza não processava nada em termos de sentido, ela era um chat bot baseado em regras. E, mesmo sendo muito simples, conseguia engajar os usuários pelo efeito de projeção de sentido.”

Segundo Torrent, a natureza cooperativa do ser humano na comunicação – conceito definido pelo filósofo da linguagem Paul Grice – é um dos fatores que contribui para o sucesso dos modelos de IA conversacional. Esse princípio consiste em quatro máximas: quantidade, qualidade, relevância e modo. O comunicador deve fornecer toda a informação necessária (quantidade), transmitir apenas informações que considera verdadeiras (qualidade), selecionar informações relevantes para o contexto (relevância) e expressá-las adequadamente (modo).

Essas máximas são aplicadas implicitamente na comunicação cotidiana. No entanto, quando interagimos com inteligências artificiais, como o ChatGPT, o principal risco surge do fato de usarmos uma inteligência artificial treinada apenas nas estruturas formais da linguagem, sem compreender seu significado. Com isso, a IA gera sequências de texto que parecem fluentes e probabilisticamente corretas em português; ou seja, é um texto adequadamente apresentado. “O problema é que estamos combinando uma inteligência artificial com uma natural, a humana, que sabe – e muito bem – construir sentido a partir de qualquer coisa.”

O pesquisador Lucas dos Anjos explica de que forma a regulação da IA está sendo discutida mundialmente (Foto: IRIS-BH)

A visão do pesquisador Lucas dos Anjos complementa a de Torrent. O primeiro argumenta que, como o ChatGPT cria uma expectativa de veracidade dos conteúdos produzidos pela plataforma, a responsabilidade de quem o utiliza é relativizada e abre caminhos para questionamentos acerca de direitos autorais, por exemplo. Torrent, exemplifica: “Se você pede para qualquer interface conversacional atual para ela escrever um trabalho e citar as referências biográficas utilizadas, ela vai gerar textos a partir de sequências de palavras probabilísticas, sem compromisso com a veracidade daqueles fatos, uma vez que ela não compreende que gera. Ela vai ‘alucinar’. Só que, quando você ler aquilo, a partir do seu engajamento cooperativo, aquela sequência de palavras vai fazer sentido.”

Nesse contexto, Dos Anjos menciona que a Rede Iberoamericana de Autoridade de Proteção de Dados, que inclui o Brasil, levantou questões sobre quais dados – pessoais ou não – estão sendo utilizados pelo ChatGPT, as finalidades do tratamento desses dados e como os direitos fundamentais dos usuários podem ser salvaguardados. Estas são questões que, segundo ele, estão sendo discutidas e incorporadas nas regulamentações de inteligência artificial. “Por exemplo, na União Europeia, uma proposta de lei sobre inteligência artificial foi elaborada para abordar preocupações específicas relacionadas ao ChatGPT”, cita Dos Anjos, afirmando que essas discussões são cruciais para moldar o futuro da inteligência artificial.

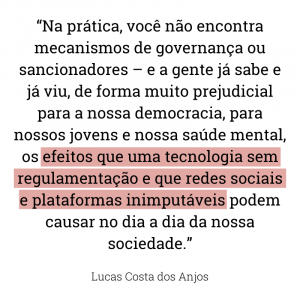

Impactos sociais – do fast food à sala de aula

Ambos os pesquisadores também abordaram o impacto social da IA. Integrante do projeto The New Digital Rule of Law, Dos Anjos explica que os pesquisadores têm observado, no contexto europeu, que somente os princípios éticos não são suficientes para regular o desenvolvimento da inteligência artificial. “É preciso ir além e procedimentalizar como esses direitos serão operacionalizados nesse novo contexto. Na prática, você não encontra mecanismos de governança ou sancionadores – e a gente já sabe e já viu, de forma muito prejudicial para a nossa democracia, para nossos jovens e nossa saúde mental, os efeitos que uma tecnologia sem regulamentação e que redes sociais e plataformas inimputáveis podem causar no dia a dia da nossa sociedade.”

Já o Brasil, segundo avaliação de Dos Anjos, tem uma base forte na área de pesquisa sobre direitos fundamentais, inclusive jurisprudencial; porém, embora avalie que nossa constituição é avançada, lamenta que ela não seja aplicada em sua extensão. “É necessário que o regulador aplique o direito já existente nesses novos contextos. Por exemplo, o consentimento, que tem sido muito discutido no contexto de privacidade e proteção de dados, já estava presente na legislação referente ao direito do consumidor. Essa é uma vantagem que a Autoridade Nacional de Proteção de Dados tem, de poder aproveitar do desenvolvimento de conceitos já existentes.”

Já o Brasil, segundo avaliação de Dos Anjos, tem uma base forte na área de pesquisa sobre direitos fundamentais, inclusive jurisprudencial; porém, embora avalie que nossa constituição é avançada, lamenta que ela não seja aplicada em sua extensão. “É necessário que o regulador aplique o direito já existente nesses novos contextos. Por exemplo, o consentimento, que tem sido muito discutido no contexto de privacidade e proteção de dados, já estava presente na legislação referente ao direito do consumidor. Essa é uma vantagem que a Autoridade Nacional de Proteção de Dados tem, de poder aproveitar do desenvolvimento de conceitos já existentes.”

Complementando a análise de Dos Anjos, Tiago Torrent enfoca a mudança em nossa relação com o trabalho, a ciência e a academia devido à ascensão da IA conversacional. Uma que o pesquisador destaca é a substituição de trabalhadores humanos por IA em setores como o fast food, onde as tarefas rotineiras e altamente parametrizáveis podem ser facilmente automatizadas. Essa tendência, argumenta ele, tem implicações sérias especialmente porque tende a afetar trabalhos de baixa remuneração e condições precárias, levantando questões sobre a dignidade e o valor do trabalho humano.

Torrent acredita que a importância do pensamento crítico e do engajamento em setores como a imprensa e a academia permanecem cruciais: por exemplo, aumentará a necessidade de verificação de fatos e combate à desinformação, dada a capacidade dessas ferramentas de gerar notícias falsas em um ritmo sem precedentes. Já na academia, está em curso uma mudança fundamental na forma como os alunos aprendem e os professores ensinam. “Em um cenário em que uma IA resume um texto, faz um fichamento, qual é o propósito de pedir esse tipo de atividade? O jeito de estudar mudou. O jeito de pensar o ensino vai mudar.”

Torrent acredita que a importância do pensamento crítico e do engajamento em setores como a imprensa e a academia permanecem cruciais: por exemplo, aumentará a necessidade de verificação de fatos e combate à desinformação, dada a capacidade dessas ferramentas de gerar notícias falsas em um ritmo sem precedentes. Já na academia, está em curso uma mudança fundamental na forma como os alunos aprendem e os professores ensinam. “Em um cenário em que uma IA resume um texto, faz um fichamento, qual é o propósito de pedir esse tipo de atividade? O jeito de estudar mudou. O jeito de pensar o ensino vai mudar.”

Dos Anjos também considera importante a incorporação de tecnologias de IA na rotina das salas de aula. Ele defende a experimentação, especialmente em ambientes educacionais, onde os alunos podem aprender sobre essas tecnologias e formar uma opinião crítica sobre elas – sem desconsiderar o que estamos deixando de exercitar em termos de capacidade cognitiva ao incluir essas ferramentas em nosso cotidiano.